Spark on Linux

WSL2에서의 Spark 설치 - Data Science | DSChloe

개요

- 간단하게 PySpark를 설치해보는 과정을 작성한다.

- WSL2 설치 방법은 다루지 않는다.

필수 파일 설치

- 설치가 안 되었을 경우에 설치한다.

- 자바 및 Spark 파일을 설치하도록 한다.

1 | $ sudo apt-get install openjdk-8-jdk |

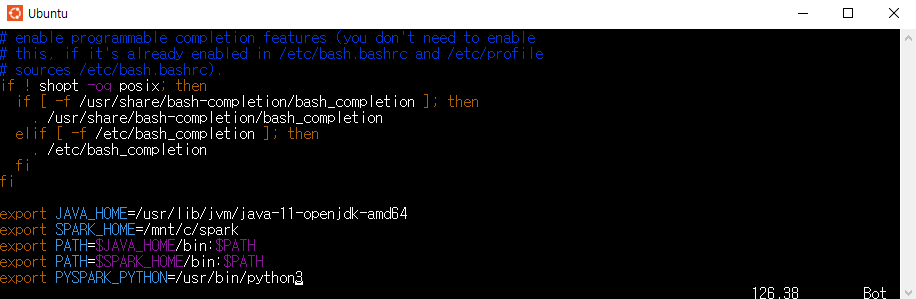

.bashrc 파일 수정

- 경로를 다음과 같이 설정한다.

1 | evan@evan:/mnt/c/hadoop$ pwd |

- 설치한 파일은 다음과 같다.

1 | evan@evan:/mnt/c/hadoop$ ls |

vi ~/.bashrc파일을 열고 다음과 같이 코드를 작성한다.- 다른 코드는 건드리지 않는다.

- 마지막 라인에서 작성한다.

1 | export JAVA_HOME=/usr/lib/jvm/java-11-openjdk-amd64 |

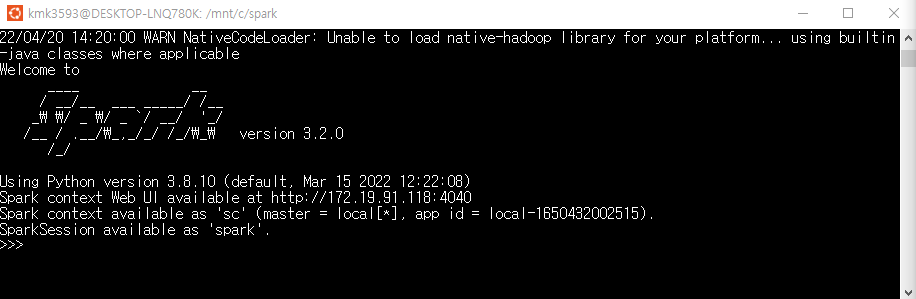

테스트

- pyspark를 실행한다. (경로에 주의한다)

- SPARK_HOME을 다음과 같이 설정했으니 해당 경로에서 실행.

- export SPARK_HOME=/mnt/c/spark

경로 이동 : cd ..

→ cd spark/

→source ~/.bashrc

→pyspark

- 정상적으로 작동한지 테스트한다.

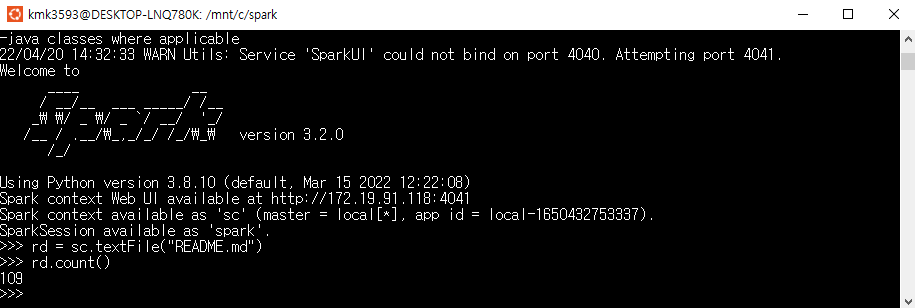

- 해당 경로에 README.md 파일이 있다면 시행해보자.

→rd = sc.textFile("README.md")

→rd.count()

→ 다음과 같이 출력된다면 성공이다.

- Reference : WSL2에서의 Spark 설치 - Data Science | DSChloe

Spark on Linux

You need to set

install_url to use ShareThis. Please set it in _config.yml.